Google и ChatGPT делают людей еще более упрямыми в их убеждениях — ученые

https://racurs.ua/n206667-google-i-chatgpt-delaut-ludey-esche-bolee-upryamymi-v-ih-ubejdeniyah-uchenye.htmlРакурсЛюди часто використовують пошукові системи таким чином, що ненавмисно підкріплюють свої наявні переконання.

Тож навіть неупереджені пошукові системи можуть завести користувачів у непроникні «цифрові ехо-камери» — просто через те, як люди формулюють свої пошукові запити. Про це свідчать результати дослідження учених з американської Freeman School of Business, повідомляє видання EurekAlert.

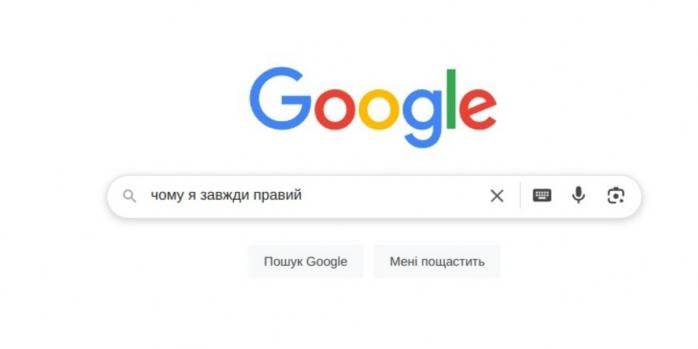

Коли люди шукають інформацію в Інтернеті — чи то в Google, ChatGPT, чи в нових пошукових системах зі штучним інтелектом — вони часто вибирають пошукові терміни, які відображають те, у що вони вже вірять (іноді навіть не усвідомлюючи цього), — наголошують дослідники.

Протягом 21 експерименту за участі майже 10 тис. учасників дослідники перевірили, як люди шукають інформацію на основних платформах.

Виявилося, що незалежно від того, цікавив користувачів кофеїн, ядерна енергія, рівень злочинності або COVID-19, їхні пошукові запити, як правило, були сформульовані таким чином, щоб відповідати їхнім попереднім думкам.

Наприклад, люди, які вважають кофеїн корисним для здоров’я, можуть шукати «користь кофеїну», тоді як скептики можуть вводити «ризики кофеїну для здоров’я». Ці ледь помітні відмінності привели їх до кардинально різних результатів пошуку, що в кінцевому підсумку зміцнило їхні початкові переконання, — вказано у статті.

Ефект зберігався навіть тоді, коли учасники не мали наміру підтверджувати упередження. У кількох дослідженнях менше 10% учасників визнали, що свідомо розробляли свої пошуки, щоб підтвердити те, що вони вже думали, але їх пошукова поведінка все ще тісно узгоджувалась із їхніми переконаннями.

Справа не лише в тому, як люди шукають і як реагують пошукові системи. Більшість з них розроблені таким чином, щоб надавати пріоритет релевантності, показуючи результати, тісно пов’язані з конкретними словами, які вводить користувач. Але ця релевантність може досягатися ціною перспективи.

Оскільки сучасні пошукові алгоритми розроблені таким чином, щоб давати «найбільш релевантні» відповіді на будь-який термін, який ви вводите, ці відповіді можуть підтверджувати те, що ви думали спочатку. Це ускладнює для людей можливість відкрити для себе ширші перспективи, — наголошують учені.

Ця динаміка зберігалася навіть для інструментів на основі штучного інтелекту, таких як ChatGPT.

Хоча у відповідях ШІ часто коротко згадувалися протилежні погляди, користувачі все одно приходили до більш сильних переконань, які відповідали спрямованості їхнього початкового запиту, — вказано у статті.

Дослідники випробували кілька способів заохотити користувачів розширити свої погляди. Просте спонукання користувачів розглянути альтернативні точки зору або виконати більше пошукових запитів мало що дало. Однак один підхід працював стабільно — зміна алгоритму:

- коли пошукові інструменти були запрограмовані на видачу ширшого спектру результатів — незалежно від того, наскільки вузьким був запит, — люди з більшою ймовірністю переглядали свої переконання;

- в одному з експериментів учасники, які побачили збалансовану добірку статей про вплив кофеїну на здоров’я, стали більш поміркованими і були більш відкритими до зміни своєї поведінки;

- користувачі оцінили ширші результати так само корисними та релевантними, як і вузькоспеціалізовані.

За словами учених, отримані дані свідчать про те, що пошукові платформи можуть мати вирішальне значення в боротьбі з поляризацією суспільства — якщо вони будуть розроблені відповідним чином.

Дослідники навіть виявили, що більшість людей зацікавлені у використанні функції «Шукати широко» — кнопки (за задумом, протилежної нинішній кнопці Google «Мені пощастить»), яка б навмисно надавала різні точки зору на певну тему, — вказано у статті.

Оскільки штучний інтелект і широкомасштабний пошук вбудовані в наше повсякденне життя, інтеграція ширшого пошукового підходу може зменшити ехо-камери для мільйонів (якщо не мільярдів) користувачів, — наголошують учені.

Джерело: EurekAlert